Sådan analyseres tekst

Miscellanea / / April 05, 2023

Hvis du har lært et par computerprogrammeringssprog, har du måske hørt udtrykket, parsing af tekst. Dette bruges til at forenkle de komplekse dataværdier i filen. Artiklen hjælper dig med at vide, hvordan du analyserer tekst ved hjælp af sproget. Ud over dette, hvis du har stået over for fejl i parse tekst x, vil du vide, hvordan du retter parse fejl i artiklen.

Indholdsfortegnelse

- Sådan analyseres tekst

- Hvad er parsing tekst?

- NLP eller Natural Language Processing

- Hvad er parsing tekst?

- Hvad er grundene til at parse tekst?

- Metode 1: Gennem DataFrame Class

- Metode 2: Gennem Word Tokenization

- Metode 3: Gennem DocParser Class

- Metode 4: Gennem Parse Text Tool

- Metode 5: Gennem TextFieldParser (Visual Basic)

- Professionelt tip: Sådan parses tekst gennem MS Excel

- Sådan rettes parse-fejl

Sådan analyseres tekst

I denne artikel har vi vist en komplet guide til at analysere tekst på forskellige måder og også kort givet en introduktion til at analysere tekst.

Hvad er parsing tekst?

Før du dykker ned for at lære begreberne at analysere tekst ved hjælp af en hvilken som helst kode. Det er vigtigt at kende til det grundlæggende i sproget og kodningen.

NLP eller Natural Language Processing

For at parse tekst bruges Natural Language Processing eller NLP, som er et underfelt af Artificial Intelligence-domænet. Python-sprog, som er et af de sprog, der hører til kategorien, bruges til at parse tekst.

NLP-koderne gør det muligt for computere at forstå og behandle menneskelige sprog for at gøre dem egnede til forskellige applikationer. For at anvende ML- eller Machine Learning-teknikker på sproget, skal de ustrukturerede tekstdata konverteres til strukturerede tabeldata. For at fuldføre parsingsaktiviteten bruges Python-sproget til at ændre programkoderne.

Hvad er parsing tekst?

At analysere tekst betyder simpelthen at konvertere data fra et format til et andet format. Formatet, som filen er gemt i, skal parses eller konverteres til en fil i et andet format for at gøre det muligt for brugeren at bruge den i forskellige applikationer.

- Med andre ord betyder processen at analysere strengen eller en tekst og konvertere til logiske komponenter ved at ændre formatet på filen.

- Nogle regler i Python-sproget bruges til at fuldføre denne almindelige programmeringsopgave. Under parsing af tekst opdeles den givne tekstserie i mindre komponenter.

Hvad er grundene til at parse tekst?

Årsagerne til, at teksten skal parses, er givet i dette afsnit, og det er en forudsætning for viden, før man ved, hvordan man analyserer tekst.

- Alle computeriserede data vil ikke være i samme format og kan variere afhængigt af forskellige applikationer.

- Dataformaterne varierer for forskellige applikationer, og en inkompatibel kode vil føre til denne fejl.

- Der er ikke noget individuelt universelt computerprogram til at vælge data for alle dataformater.

Metode 1: Gennem DataFrame Class

DataFrame-klassen i Python-sproget har alle de nødvendige funktioner til at parse tekst. Dette indbyggede bibliotek rummer de nødvendige koder til at parse data af ethvert format til et andet format.

Kort introduktion til DataFrame Class

DataFrame Class er en funktionsrig datastruktur, som bruges som et dataanalyseværktøj. Dette er et kraftfuldt dataanalyseværktøj, der kan bruges til at analysere data med minimal indsats.

- Koden læses ind i pandas DataFrame for at udføre analysen i Python-sproget.

- Klassen leveres med adskillige pakker leveret af pandaerne, som bruges af Python-dataanalytikere.

- Funktionen i denne klasse er en abstraktion, en kode, hvori den interne funktionalitet af funktionen er skjult for brugerne, i NumPy-biblioteket. NumPy-biblioteket er et python-bibliotek, der omfatter kommandoer og funktioner til at arbejde med arrays.

- DataFrame-klassen kan bruges til at gengive et todimensionelt array med flere række- og kolonneindekser. Disse indekser hjælper med at gemme multidimensionelle data og kaldes derfor MultiIndex. Disse skal ændres for at vide, hvordan man løser parse-fejl.

Python-sprogets pandaer hjælper med at udføre SQL- eller databaselignende operationer med den største perfektion for at undgå fejl i parse tekst x. Den indeholder også nogle IO-værktøjer, der hjælper med at analysere filerne i CSV, MS Excel, JSON, HDF5 og andre dataformater.

Læs også:Ret fejl, der opstod under forsøg på at proxy-anmodning

Proces med at analysere tekst ved hjælp af DataFrame Class

For at vide, hvordan man parser tekst, kan du bruge standardprocessen ved hjælp af DataFrame Class givet i dette afsnit.

- Dechifrer dataformatet for inputdataene.

- Bestem outputdataene for dataene som f.eks CSV eller Kommasepareret værdi.

- Skriv på koden en primitiv datatype som liste eller diktat.

Bemærk: At skrive koden på en tom DataFrame kan være kedeligt og komplekst. Pandaerne tillader at skabe data på DataFrame-klassen fra disse datatyper. Derfor kan dataene i den primitive datatype let parses til det krævede dataformat.

- Analyser dataene ved hjælp af dataanalyseværktøjet, pandas DataFrame, og udskriv resultatet.

Mulighed I: Standardformat

Standardmetoden til at formatere enhver fil med et bestemt dataformat, såsom CSV, er forklaret her.

- Gem filen med dataværdierne lokalt på din pc. For eksempel kan du navngive filen data.txt.

- Importer filen i pandaer med et specifikt navn og importer dataene til en anden variabel. For eksempel er sprogets pandaer importeret til navnet pd i den angivne kode.

- Importen skal have en komplet kode med detaljerne i navnet på inputfilen, funktionen og inputfilformatet.

Bemærk: Her hedder variablen res bruges til at udføre Læs funktion af dataene i filen data.txt ved hjælp af pandaerne importeret i pd. Dataformatet for inputteksten er angivet i CSV format.

- Kald den navngivne filtype og analyser den parsede tekst på det udskrevne resultat. For eksempel kommandoen res efter kommandolinjens udførelse vil hjælpe med at udskrive den analyserede tekst.

Et eksempel på en kode for processen forklaret ovenfor er givet nedenfor og vil hjælpe med at forstå, hvordan man analyserer tekst.

importer pandaer som pdres = pd.read_csv(‘data.txt’)res

I dette tilfælde, hvis du indtaster dataværdierne i filen data.txt såsom [1,2,3], ville det blive parset og vist som 1 2 3.

Mulighed II: Strengmetode

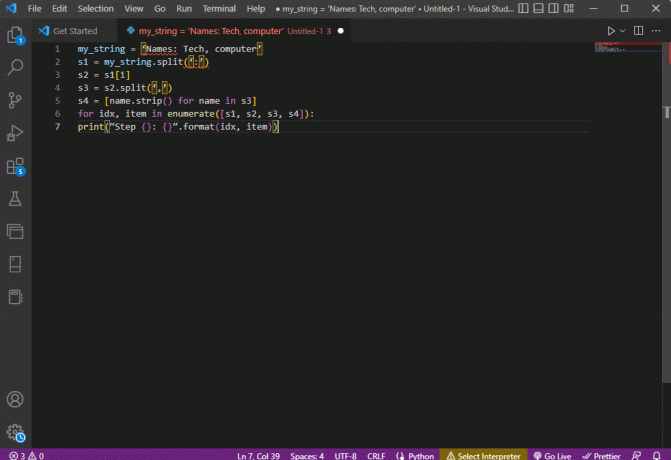

Hvis teksten givet til koden kun indeholder strenge eller alfategn, kan specialtegnene i strengen såsom kommaer, mellemrum osv. bruges til at adskille og parse teksten. Processen ligner de almindelige interne strengoperationer. For at finde ud af, hvordan du løser parse-fejl, skal du følge processen med at analysere teksten ved at bruge denne mulighed, som er forklaret nedenfor.

- Dataene udtrækkes fra strengen, og alle de specialtegn, der adskiller teksten, noteres.

For eksempel i koden nedenfor, specialtegnene i strengen min_streng, som er, ',' og ':’ er identificeret. Denne proces skal udføres omhyggeligt for at undgå fejl i parse tekst x.

- Teksten i strengen opdeles individuelt baseret på værdierne og placeringen af specialtegnene.

For eksempel er strengen opdelt i tekstdataværdier baseret på de specialtegn, der identificeres ved hjælp af split-kommandoen.

- Strengens dataværdier udskrives alene som den analyserede tekst. Her, den Print sætning bruges til at udskrive den parsede dataværdi af teksten.

Eksempelkoden for processen forklaret ovenfor er givet nedenfor.

my_string = 'Navne: Teknik, computer'sfinal = [name.strip() for navn i my_string.split(':')[1].split(',')]print("Navne: {}".format (sfinal))

I dette tilfælde vil resultatet af den parsede streng blive vist som vist nedenfor.

Navne: ['Tech', 'computer']

For at få bedre klarhed og vide, hvordan man analyserer tekst, mens du bruger strengteksten, a til loop anvendes, og koden ændres som følger.

my_string = 'Navne: Teknik, computer's1 = min_streng.split(':')s2 = s1[1]s3 = s2.split(‘,’)s4 = [name.strip() for navn i s3]for idx, element i enumerate([s1, s2, s3, s4]):print("Trin {}: {}".format (idx, element))

Resultatet af den analyserede tekst for hvert af disse trin vises som vist nedenfor. Du kan bemærke, at i trin 0 er strengen adskilt baseret på specialtegnet : og tekstdataværdierne adskilles baseret på tegnet i yderligere trin.

Trin 0: ['Navne', 'Tech, computer']Trin 1: Teknik, computerTrin 2: ['Tech', 'computer']Trin 3: ['Tech', 'computer']

Mulighed III: Parsing af kompleks fil

I de fleste tilfælde indeholder fildataene, der skal parses, forskellige datatyper og dataværdier. I dette tilfælde kan det være svært at parse filen ved hjælp af de metoder, der er forklaret tidligere.

Funktionerne ved at parse de komplekse data i filen er at få dataværdierne til at blive vist i et tabelformat.

- Værdiernes titel eller metadata udskrives øverst i filen,

- Variablerne og felterne udskrives i outputtet i tabelform, og

- Dataværdierne danner en sammensat nøgle.

Før du dykker ned i at lære at analysere tekst i denne metode, er det nødvendigt at lære et par grundlæggende begreber. Parsingen af dataværdierne udføres baseret på regulære udtryk eller Regex.

Regex mønstre

For at vide, hvordan man løser parse-fejl, skal du sikre dig, at regex-mønstrene i udtrykkene er korrekte. Koden til at parse strengenes dataværdier ville involvere de almindelige Regex-mønstre, der er angivet nedenfor i dette afsnit.

- '\d': matcher decimaltallet i strengen,

- '\s': matcher mellemrummets tegn,

- '\w': matcher det alfanumeriske tegn,

- ‘+’ eller ‘*’: udfører en grådig match ved at matche en eller flere tegn i strengene,

- 'a-z': matcher grupperne med små bogstaver i tekstdataværdierne,

- 'A-Z' eller 'a-z': matcher de store og små bogstaver i strengen, og

- ‘0-9’: matcher de numeriske værdier.

Regelmæssige udtryk

Regulære udtryksmoduler er en stor del af pandas-pakken i Python-sproget, og en forkert gengivelse kan føre til en fejl i parse tekst x. Det er et lillebitte sprog indlejret i Python for at finde strengmønsteret i udtrykket. Regulære udtryk eller Regex er strenge med speciel syntaks. Det giver brugeren mulighed for at matche mønstre i andre strenge baseret på værdierne i strengene.

Regex oprettes baseret på datatypen og kravet til udtrykket i strengen, som f.eks Streng = (.*)\n. Regex bruges før mønsteret i hvert udtryk. Symbolerne, der bruges i de regulære udtryk, er anført nedenfor og vil hjælpe med at vide, hvordan man analyserer tekst.

- .: for at hente et hvilket som helst tegn fra dataene,

- *: brug nul eller flere data fra det forrige udtryk,

- (.*): at gruppere en del af det regulære udtryk inden for parentes,

- \n: Opret et nyt linjetegn i slutningen af linjen i kode,

- \d: opret en kort integralværdi i området 0 til 9,

- +: brug en eller flere data fra det forrige udtryk, og

- |: opret en logisk erklæring; anvendes til eller udtryk.

RegexObjects

RegexObject er en returværdi for kompileringsfunktionen og bruges til at returnere et MatchObject, hvis udtrykket matcher matchværdien.

1. MatchObject

Da den boolske værdi af MatchObject altid er True, kan du bruge en hvis sætning for at identificere de positive match i objektet. I tilfælde af brug af hvis sætning, bruges den gruppe, som indekset henviser til, til at finde ud af, om objektet i udtrykket passer.

- gruppe() returnerer en eller flere undergrupper af match,

- gruppe (0) returnerer hele kampen,

- gruppe (1) returnerer den første undergruppe i parentes, og

- Mens vi henviser til flere grupper, bør vi bruge en python-specifik udvidelse. Denne udvidelse bruges til at angive navnet på den gruppe, hvor matchen skal findes. Den specifikke udvidelse er angivet i gruppen i parentes. For eksempel udtrykket, (?P

regex1) ville referere til den specifikke gruppe med navnet gruppe 1 og tjek for match i det regulære udtryk, regex1. For at lære at rette parse-fejl, skal du kontrollere, om gruppen peger korrekt.

2. Metoder til MatchObject

Mens du finder ud af, hvordan man analyserer tekst, er det vigtigt at vide, at MatchObject har to grundlæggende metoder som anført nedenfor. Hvis MatchObject findes i det angivne udtryk, ville det returnere sin instans, ellers ville det returnere Ingen.

- Det match (streng) metode bruges til at finde overensstemmelser med strengen i begyndelsen af det regulære udtryk, og

- Det søg (streng) metode bruges til at scanne gennem strengen for at finde placeringen for et match i det regulære udtryk.

Regulære udtryksfunktioner

Regex-funktioner er kodelinjer, der bruges til at udføre en bestemt funktion, som angivet af brugeren fra det anskaffede sæt af dataværdier.

Bemærk: For at skrive funktionerne bruges rå strenge til de regulære udtryk for at undgå fejl i parse tekst x. Dette gøres ved at tilføje subscriptet r før hvert mønster i udtrykket.

De almindelige funktioner, der bruges i udtrykkene, er forklaret nedenfor.

1. re.findall()

Denne funktion returnerer alle mønstrene i strengen, hvis der findes et match, og returnerer en tom liste, hvis der ikke findes et match. For eksempel funktionen, string = re.findall('[aeiou]', regex_filnavn) bruges til at finde vokalforekomsten i filnavnet.

2. re.split()

Denne funktion bruges til at opdele strengen i tilfælde af et match med et angivet tegn, såsom mellemrum. Hvis der ikke findes noget match, returnerer det en tom streng.

3. re.sub()

Funktionen erstatter den matchede tekst med indholdet af den givne erstatningsvariabel. I modsætning til andre funktioner, hvis der ikke findes noget mønster, returneres den oprindelige streng.

4. forskning()

En af de grundlæggende funktioner til at hjælpe med at lære at analysere tekst er søgefunktionen. Det hjælper med at søge efter mønsteret i strengen og returnere matchobjektet. Hvis søgningen mislykkes med at identificere matchet, returneres ingen værdi.

5. re.compile (mønster)

Denne funktion bruges til at kompilere regulære udtryksmønstre i et RegexObject, som blev diskuteret tidligere.

Andre krav

De anførte krav er en ekstra funktion, der bruges af avancerede programmører i dataanalyse.

- For at visualisere det regulære udtryk, regexper bruges, og

- For at teste det regulære udtryk, regex101 anvendes.

Læs også:Sådan installeres NumPy på Windows 10

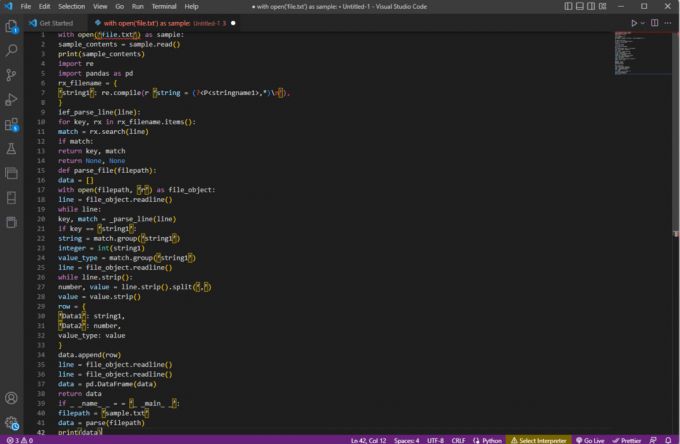

Processen med at analysere tekst

Metoden til at parse teksten i denne komplekse mulighed er beskrevet som angivet nedenfor.

- Det forreste trin er at forstå inputformatet ved at læse indholdet af filen. For eksempel med åben og Læs() funktioner bruges til at åbne og læse indholdet af den navngivne fil prøve. Det prøve filen har indholdet fra filen file.txt; for at lære at rette parse-fejl, skal filen læses fuldstændigt.

- Indholdet af filen udskrives for at analysere dataene manuelt for at finde ud af værdiernes metadata. Her, den Print() funktionen bruges til at udskrive indholdet af prøve fil.

- De nødvendige datapakker til at parse teksten importeres til koden og et navn gives til klassen for yderligere kodning. Her, den regulære udtryk og pandaer er importeret.

- De regulære udtryk, der kræves til koden, er defineret i filen ved at inkludere regex-mønsteret og regex-funktionen. Dette gør det muligt for tekstobjektet eller korpuset at tage koden til dataanalyse.

- For at vide, hvordan man analyserer tekst, kan du henvise til eksempelkoden givet her. Det udarbejde() funktion bruges til at kompilere strengen fra gruppen strengnavn1 af filen filnavn. Funktionen til at tjekke for match i regex bruges af kommandoen ief_parse_line (linje),

- Linjeparser for koden skrives ved hjælp af def_parse_file (filsti), hvor den definerede funktion kontrollerer for alle regex-matches i den angivne funktion. Her regex Søg() metode søger efter nøglen rx i filen filnavn og returnerer nøglen og match for det første matchende regex. Ethvert problem med trinnet kan føre til en fejl i parse tekst x.

- Det næste trin er at skrive en filparser ved hjælp af filparserfunktionen, som er def_parse_file (filsti). Der oprettes en tom liste for at indsamle kodens data, som data = [], overensstemmelsen kontrolleres ved hver linje af match = _parse_line (linje), og de nøjagtige værdidata returneres baseret på datatypen.

- For at udtrække tallet og værdien for tabellen, kommandoen line.strip().split(',') anvendes. Det række{} kommando bruges til at oprette en ordbog med rækken af data. Det data.append (række) kommandoen bruges til at forstå dataene og analysere dem til et tabelformat.

Kommandoen data = pd. DataFrame (data) bruges til at skabe en pandas DataFrame ud fra dict-værdierne. Alternativt kan du bruge følgende kommandoer til det respektive formål som angivet nedenfor.

- data.set_index(['streng', 'heltal'], inplace=True) for at indstille indekset for tabellen.

- data = data.groupby (level=data.index.names).first() at konsolidere og fjerne nans.

- data = data.apply (pd.to_numeric, errors='ignore') at opgradere score fra flydende til heltalsværdi.

Det sidste trin for at vide, hvordan man analyserer tekst, er at teste parseren ved hjælp af hvis erklæring ved at tildele værdierne til en variabel data og udskrive den ved hjælp af print (data) kommando.

Eksempelkoden til forklaringen ovenfor er givet her.

med open('file.txt') som eksempel:sample_contents = sample.read()print (sample_contents)import vedrimporter pandaer som pdrx_filename = {'string1': re.compile (r 'string = (?,*)\n’),

}ief_parse_line (linje):for nøgle, rx i rx_filename.items():match = rx.search (linje)hvis match:returnøgle, matchretur Ingen, Ingendef parse_file (filsti):data = []med åben (filsti, 'r') som fil_objekt:line = file_object.readline()mens linje:nøgle, match = _parse_line (linje)hvis nøgle == 'streng1':string = match.group(‘string1’)heltal = int (streng1)værdi_type = match.group('streng1')line = file_object.readline()while line.strip():tal, værdi = line.strip().split(',')værdi = værdi.strimmel()række = {'Data1': streng1,'Data2': nummer,værditype: værdi}data.append (række)line = file_object.readline()line = file_object.readline()data = pd. DataFrame (data)returnere datahvis _ _navn_ _ = = '_ _main_ _':filsti = 'sample.txt'data = parse (filsti)print (data)

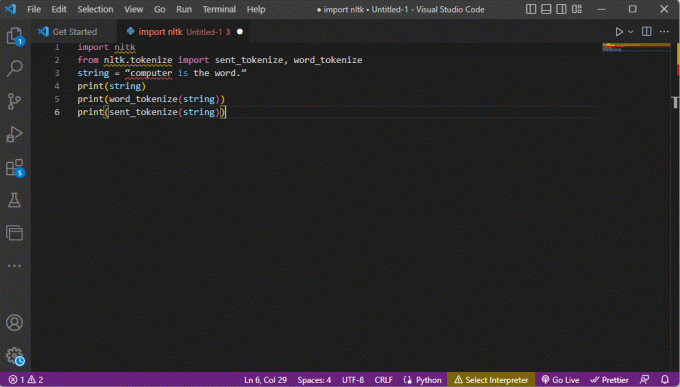

Metode 2: Gennem Word Tokenization

Processen med at konvertere en tekst eller et korpus til tokens eller mindre stykker baseret på visse regler kaldes tokenisering. For at lære at rette parse-fejl er det vigtigt at analysere ordtokeniseringskommandoer i koden. I lighed med regex kan egne regler oprettes i denne metode, og den hjælper med tekstforbehandlingsopgaver såsom at kortlægge dele af tale. Også aktiviteter som at finde og matche almindelige ord, rense tekst og gøre dataene klar til avancerede tekstanalyseteknikker som følelsesanalyse udføres i denne metode. Hvis tokeniseringen er forkert, kan der opstå fejl i parse tekst x.

NLTK bibliotek

Processen tager hjælp af det populære sprogværktøjsbibliotek kaldet NLTK, som har et rigt sæt funktioner til at udføre mange NLP-job. Disse kan downloades gennem Pip- eller Pip-installationspakkerne. For at vide, hvordan man analyserer tekst, kan du bruge basispakken til Anaconda-distributionen, som inkluderer biblioteket som standard.

Former for tokenisering

De almindelige former for denne metode er ord-tokenisering og sætningstokenisering. På grund af symbolet på ordniveau udskriver førstnævnte kun ét ord én gang, mens sidstnævnte udskriver ordet på sætningsniveau.

Processen med at analysere tekst

- NLTK-værktøjskassebiblioteket importeres, og tokeniseringsformularerne importeres fra biblioteket.

- Der gives en streng, og kommandoerne til at udføre tokeniseringen er givet.

- Mens strengen udskrives, ville outputtet være computer er ordet.

- I tilfælde af ordtokenisering eller word_tokenize(), hvert af ordene i sætningen udskrives individuelt inden for ‘’ og er adskilt af en komma. Outputtet for kommandoen ville være 'computer', 'er', 'det', 'ord', '.'

- I tilfælde af sætningstokenisering eller sendt_tokenize(), er de enkelte sætninger placeret inden for ‘’ og ordet gentagelse er tilladt. Outputtet for kommandoen ville være 'computer er ordet.'

Koden, der forklarer trinene til tokenisering ovenfor, er givet her.

import nltkfra nltk.tokenize import send_tokenize, word_tokenizestring = "computer er ordet."print (streng)print (word_tokenize (streng))print (sent_tokenize (streng))

Læs også:Sådan rettes javascript: void (0) Fejl

Metode 3: Gennem DocParser Class

I lighed med DataFrame-klassen kan Class DocParser bruges til at parse teksten i koden. Klassen giver dig mulighed for at kalde parse-funktionen med filstien.

Processen med at analysere tekst

For at vide, hvordan man analyserer tekst ved hjælp af DocParser-klassen, skal du følge instruktionerne nedenfor.

- Det get_format (filnavn) funktion bruges til at udtrække filtypenavnet, returnere det til en indstillet variabel for funktionen og videregive det til den næste funktion. For eksempel, p1 = get_format (filnavn) ville udpakke filtypenavnet på filnavn, indstil den til variablen p1, og send den til den næste funktion.

- En logisk struktur med andre funktioner er konstrueret ved hjælp af hvis-elif-else udsagn og funktioner.

- Hvis filtypenavnet er gyldigt, og strukturen er logisk, vil get_parser funktion bruges til at parse dataene i filstien og returnere strengobjektet til brugeren.

Bemærk: For at vide, hvordan man løser parse-fejl, skal denne funktion implementeres korrekt.

- Parsingen af dataværdierne udføres med filens filtypenavn. Den konkrete implementering af klassen, som er parse_txt eller parse_docx bruges til at generere strengobjekter fra delene af den givne filtype.

- Parsingen kan udføres for filer med andre læsbare udvidelser som f.eks parse_pdf, parse_html, og parse_pptx.

- Dataværdierne og grænsefladen kan importeres til applikationer med importerklæringer og instansiere et DocParser-objekt. Dette kan gøres ved at parse filer i Python-sproget, som f.eks parse_file.py. Denne handling skal udføres omhyggeligt for at undgå fejl i parse tekst x.

Metode 4: Gennem Parse Text Tool

Parse tekstværktøjet bruges til at udtrække specifikke data fra variabler og kortlægge dem til andre variabler. Dette er uafhængigt af andre værktøjer, der bruges i en opgave, og BPA Platform-værktøjet bruges til at forbruge og udlæse variabler. Brug linket her for at få adgang til Parse Text Tool online og brug de svar, der er givet tidligere om, hvordan man analyserer tekst.

Metode 5: Gennem TextFieldParser (Visual Basic)

TextFieldParser brugte objekter til at parse og behandle meget store filer, der er strukturerede og afgrænsede. Bredden og kolonnen af tekst såsom logfiler eller ældre databaseoplysninger kan bruges i denne metode. Parsingmetoden ligner at iterere koden over en tekstfil og bruges hovedsageligt til at udtrække tekstfelter, der ligner strengmanipulationsmetoder. Dette gøres for at tokenisere afgrænsede strenge og felter med forskellige bredder ved hjælp af den definerede afgrænsning, såsom komma eller tabulatormellemrum.

Funktioner til at analysere tekst

Følgende funktioner kan bruges til at analysere teksten i denne metode.

- For at definere en afgrænsning skal SetDelimiters anvendes. For eksempel kommandoen testlæser. SetDelimiters (vbTab) bruges til at indstille fanen rum som afgrænsning.

- For at indstille en feltbredde til en positiv heltalværdi til en fast feltbredde af tekstfiler, kan du bruge testlæser. SetFieldWidths (heltal) kommando.

- For at teste tekstens felttype kan du bruge følgende kommando testlæser. TextFieldType = Microsoft. VisualBasic. FileIO.FieldType. FixedWidth.

Metoder til at finde MatchObject

Der er to grundlæggende metoder til at finde MatchObject i koden eller den parsede tekst.

- Den første metode er at definere formatet og gennemgå filen ved hjælp af Læsefelter metode. Denne metode vil hjælpe med at behandle hver linje i koden.

- Det PeekChars metode bruges til at kontrollere hvert felt individuelt, før du læser det, definere flere formater og reagere.

I begge tilfælde, hvis et felt ikke matcher det angivne format, mens du udfører parsing eller finder, hvordan man parser tekst, en MalformedLineException undtagelse returneres.

Professionelt tip: Sådan parses tekst gennem MS Excel

Som en sidste og enkel metode til at parse teksten kan du bruge MS Excel app som en parser til at oprette tabulatorseparerede og kommaseparerede filer. Dette vil hjælpe med at krydstjekke med dit parsede resultat og hjælpe med at finde ud af, hvordan man løser parse-fejl.

1. Vælg dataværdierne i kildefilen, og tryk på Ctrl + C-tasterne sammen for at kopiere filen.

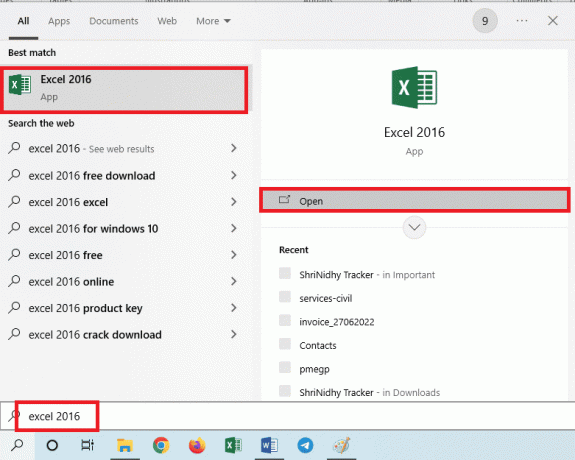

2. Åbn Excel app ved hjælp af Windows-søgelinjen.

3. Klik på A1 celle og tryk på Ctrl + V tasterne samtidig for at indsætte den kopierede tekst.

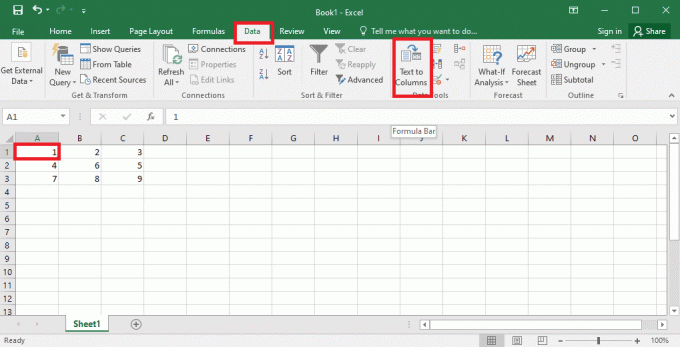

4. Vælg A1 celle, naviger til Data fanen, og klik på Tekst til kolonner mulighed i Dataværktøjer afsnit.

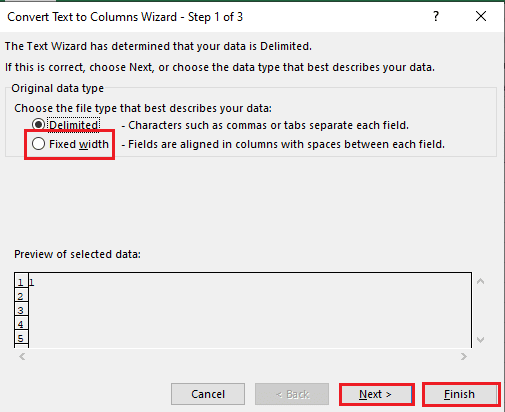

5A. Vælg Afgrænset mulighed hvis en komma eller fanen plads bruges som separator, og klik på Næste og Afslut knapper.

5B. Vælg Fast bredde valgmulighed, tildel en værdi for separatoren, og klik på Næste og Afslut knapper.

Læs også:Sådan rettes Flyt Excel-kolonnefejl

Sådan rettes parse-fejl

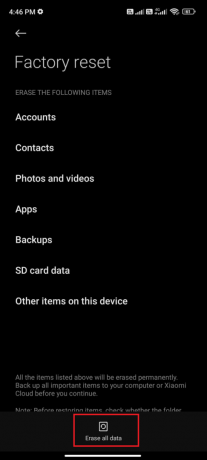

Fejl i parse tekst x kan forekomme på Android-enheder som, Parse Error: Der var et problem med at parse pakken. Dette sker normalt, når appen ikke kan installeres fra Google Play Butik, eller mens du kører en tredjepartsapp.

Fejlteksten x kan forekomme, hvis listen over tegnvektorer er sløjfet, og andre funktioner danner en lineær model til beregning af dataværdierne. Fejlmeddelelsen er Error in parse (tekst = x, keep.source = FALSE):

Du kan læse artiklen på hvordan man løser parse-fejl på Android at lære årsagerne og metoderne til at rette fejlen.

Ud over løsningerne i vejledningen kan du prøve følgende rettelser.

- Gendownload af .apk fil eller gendannelse af navnet på filen.

- Gendannelse af ændringer i Androidmanifest.xml fil, hvis du har programmeringsfærdigheder på ekspertniveau.

Anbefalede:

- Sådan sletter du en andens Facebook-konto

- Top 10 færdigheder, der kræves for at blive en etisk hacker

- 21 bedste Pastebin-alternativer til at dele kode og tekst

- Fix kommando mislykkedes med fejlkode 1 Python Egg Info

Artiklen hjælper i undervisningen hvordan man analyserer tekst og for at lære at rette parse-fejl. Fortæl os, hvilken metode der hjalp med at rette fejl i parse tekst x, og hvilken metode til parsing der foretrækkes. Del venligst dine forslag og spørgsmål i kommentarfeltet nedenfor.