Como Analisar Texto

Miscelânea / / April 05, 2023

Se você aprendeu algumas linguagens de programação de computador, pode ter ouvido o termo, análise de texto. Isso é usado para simplificar os valores de dados complexos do arquivo. O artigo ajuda você a saber como analisar o texto usando o idioma. Além disso, se você encontrou um erro na análise do texto x, saberá como corrigir o erro de análise no artigo.

Índice

- Como Analisar Texto

- O que é análise de texto?

- PNL ou Processamento de Linguagem Natural

- O que é análise de texto?

- Quais são as razões para analisar o texto?

- Método 1: por meio da classe DataFrame

- Método 2: Através da Tokenização do Word

- Método 3: por meio da classe DocParser

- Método 4: Através da Ferramenta Analisar Texto

- Método 5: Através de TextFieldParser (Visual Basic)

- Dica Profissional: Como Analisar Texto Através do MS Excel

- Como corrigir erro de análise

Como Analisar Texto

Neste artigo, mostramos um guia completo para analisar texto de várias maneiras e também apresentamos brevemente uma introdução à análise de texto.

O que é análise de texto?

Antes de mergulhar para aprender os conceitos de análise de texto usando qualquer código. É importante saber sobre o básico da linguagem e da codificação.

PNL ou Processamento de Linguagem Natural

Para analisar o texto, utiliza-se o Processamento de Linguagem Natural ou NLP, que é um subcampo do domínio da Inteligência Artificial. A linguagem Python, que é uma das linguagens que pertencem à categoria, é usada para analisar o texto.

Os códigos NLP permitem que os computadores entendam e processem linguagens humanas para torná-los adequados para várias aplicações. Para aplicar técnicas de ML ou Machine Learning ao idioma, os dados de texto não estruturados devem ser convertidos em dados tabulares estruturados. Para completar a atividade de análise, a linguagem Python é usada para alterar os códigos do programa.

O que é análise de texto?

Analisar texto significa simplesmente converter os dados de um formato para outro formato. O formato no qual o arquivo é salvo deve ser analisado ou convertido em um arquivo em um formato diferente para permitir que o usuário o use em vários aplicativos.

- Em outras palavras, o processo significa analisar a string ou um texto e convertê-lo em componentes lógicos alterando o formato do arquivo.

- Algumas regras da linguagem Python são utilizadas para completar esta tarefa comum de programação. Ao analisar o texto, a determinada série de texto é dividida em componentes menores.

Quais são as razões para analisar o texto?

As razões pelas quais o texto deve ser analisado são dadas nesta seção e é um pré-requisito de conhecimento antes de saber como analisar o texto.

- Todos os dados computadorizados não estarão no mesmo formato e podem diferir de acordo com várias aplicações.

- Os formatos de dados variam para vários aplicativos e um código incompatível levaria a esse erro.

- Não existe um programa de computador universal individual para selecionar os dados de todos os formatos de dados.

Método 1: por meio da classe DataFrame

A classe DataFrame da linguagem Python possui todas as funções necessárias para analisar o texto. Esta biblioteca embutida abriga os códigos necessários para analisar dados de qualquer formato para outro formato.

Breve introdução da classe DataFrame

DataFrame Class é uma estrutura de dados rica em recursos, que é usada como uma ferramenta de análise de dados. Esta é uma poderosa ferramenta de análise de dados que pode ser usada para analisar dados com o mínimo de esforço.

- O código é lido no DataFrame do pandas para realizar a análise na linguagem Python.

- A classe vem com vários pacotes fornecidos pelos pandas que são usados pelos analistas de dados do Python.

- A característica desta classe é uma abstração, um código no qual a funcionalidade interna da função fica escondida dos usuários, da biblioteca NumPy. A biblioteca NumPy é uma biblioteca python que engloba os comandos e funções para trabalhar com arrays.

- A classe DataFrame pode ser usada para renderizar uma matriz bidimensional com vários índices de linha e coluna. Esses índices ajudam no armazenamento de dados multidimensionais e, portanto, são chamados de MultiIndex. Estes devem ser alterados para saber como corrigir o erro de análise.

Os pandas da linguagem Python ajudam na execução das operações SQL ou no estilo de banco de dados com a máxima perfeição para evitar erros na análise do texto x. Ele também contém algumas ferramentas de IO que ajudam na análise de arquivos CSV, MS Excel, JSON, HDF5 e outros formatos de dados.

Leia também:Corrigir o erro ocorrido ao tentar a solicitação de proxy

Processo de análise de texto usando a classe DataFrame

Para saber como analisar o texto, você pode usar o processo padrão usando a classe DataFrame fornecida nesta seção.

- Decifre o formato de dados dos dados de entrada.

- Decida os dados de saída dos dados, como CSV ou Valor separado por vírgula.

- Escreva no código um tipo de dado primitivo como lista ou ditado.

Observação: Escrever o código em um DataFrame vazio pode ser tedioso e complexo. Os pandas permitem criar os dados na classe DataFrame a partir desses tipos de dados. Portanto, os dados no tipo de dados primitivo podem ser facilmente analisados para o formato de dados necessário.

- Analise os dados usando a ferramenta de análise de dados, pandas DataFrame, e imprima o resultado.

Opção I: Formato Padrão

O método padrão para formatar qualquer arquivo com um determinado formato de dados, como CSV, é explicado aqui.

- Salve o arquivo com os valores de dados localmente em seu PC. Por exemplo, você pode nomear o arquivo dados.txt.

- Importe o arquivo em pandas com um nome específico e importe os dados para outra variável. Por exemplo, os pandas do idioma são importados para o nome pd no código dado.

- A importação deve ter um código completo com o detalhe do nome do arquivo de entrada, a função e o formato do arquivo de entrada.

Observação: Aqui, a variável chamada res é usado para realizar o ler função dos dados no arquivo dados.txt usando os pandas importados em pd. O formato de dados do texto de entrada é especificado no CSV formatar.

- Chame o tipo de arquivo nomeado e analise o texto analisado no resultado impresso. Por exemplo, o comando res após a execução da linha de comando ajudará na impressão do texto analisado.

Um código de exemplo para o processo explicado acima é fornecido abaixo e ajudará a entender como analisar o texto.

importar pandas como pdres = pd.read_csv('data.txt')res

Nesse caso, se você inserir os valores de dados no arquivo dados.txt como [1,2,3], seria analisado e exibido como 1 2 3.

Opção II: Método String

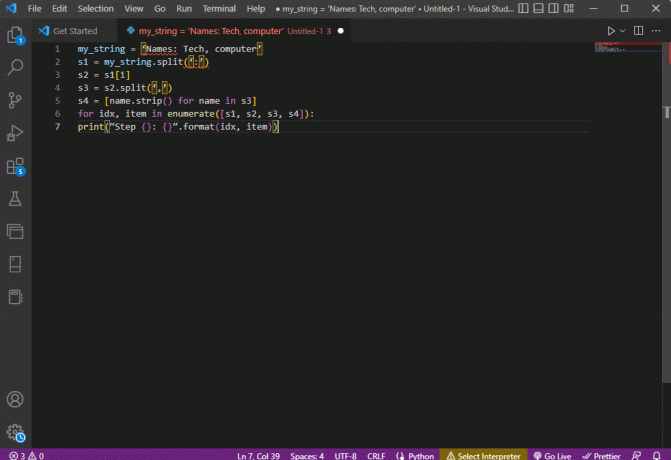

Se o texto fornecido ao código contiver apenas strings ou caracteres alfa, os caracteres especiais na string, como vírgulas, espaço etc., podem ser usados para separar e analisar o texto. O processo é semelhante às operações de string internas comuns. Para descobrir como corrigir o erro de análise, você deve seguir o processo de análise do texto usando esta opção explicada abaixo.

- Os dados são extraídos da string e todos os caracteres especiais que separam o texto são anotados.

Por exemplo, no código abaixo, os caracteres especiais na string minha_cadeia, que são, ',' e ':’ são identificados. Este processo deve ser feito com cuidado para evitar erros na análise do texto x.

- O texto na string é dividido individualmente com base nos valores e na posição dos caracteres especiais.

Por exemplo, a string é dividida em valores de dados de texto com base nos caracteres especiais identificados usando o comando split.

- Os valores de dados da string são impressos sozinhos como o texto analisado. Aqui o imprimir A instrução é usada para imprimir o valor dos dados analisados do texto.

O código de exemplo para o processo explicado acima é fornecido abaixo.

my_string = 'Nomes: Tecnologia, computador'sfinal = [name.strip() para nome em my_string.split(':')[1].split(',')]print(“Nomes: {}”.formato (sfinal))

Nesse caso, o resultado da string analisada seria exibido conforme mostrado abaixo.

Nomes: ['Tecnologia', 'computador']

Para obter melhor clareza e saber como analisar o texto enquanto usa a string text, um para loop é utilizado e o código é modificado da seguinte maneira.

my_string = 'Nomes: Tecnologia, computador's1 = minha_string.split(':')s2 = s1[1]s3 = s2.split(',')s4 = [name.strip() para nome em s3]para idx, item em enumerate([s1, s2, s3, s4]):print(“Etapa {}: {}”.format (idx, item))

O resultado do texto analisado para cada uma dessas etapas é exibido conforme abaixo. Você pode notar que, na Etapa 0, a string é separada com base no caractere especial : e os valores de dados de texto são separados com base no caractere em etapas posteriores.

Etapa 0: ['Nomes', 'Tecnologia, computador']Passo 1: Tecnologia, computadorEtapa 2: [‘Tecnologia’, ‘computador’]Etapa 3: ['Tecnologia', 'computador']

Opção III: Analisando Arquivo Complexo

Na maioria dos casos, os dados do arquivo que precisam ser analisados contêm vários tipos de dados e valores de dados. Nesse caso, pode ser difícil analisar o arquivo usando os métodos explicados anteriormente.

Os recursos de análise dos dados complexos no arquivo são para fazer com que os valores dos dados sejam exibidos em um formato tabular.

- O Título ou Metadados dos valores é impresso na parte superior do arquivo,

- As variáveis e os campos são impressos na saída em forma de tabela e

- Os valores de dados formam uma chave composta.

Antes de mergulhar no aprendizado de como analisar texto neste método, é necessário aprender alguns conceitos básicos. A análise dos valores dos dados é feita com base em expressões regulares ou Regex.

Padrões Regex

Para saber como corrigir o erro de análise, você deve garantir que os padrões regex nas expressões sejam adequados. O código para analisar os valores de dados das strings envolveria os padrões Regex comuns listados abaixo nesta seção.

- '\d': corresponde ao dígito decimal na string,

- '\s': corresponde ao caractere de espaço em branco,

- '\c': corresponde ao caractere alfanumérico,

- ‘+’ ou ‘*’: executa uma correspondência gulosa combinando um ou mais caracteres nas strings,

- 'a-z': corresponde aos grupos de minúsculas nos valores de dados de texto,

- 'A-Z' ou 'a-z': corresponde aos grupos de letras maiúsculas e minúsculas da string e

- ‘0-9’: corresponde aos valores numéricos.

Expressões regulares

Os módulos de expressão regular são uma parte importante do pacote pandas na linguagem Python e um re errado pode levar a um erro na análise do texto x. É uma pequena linguagem embutida dentro do Python para encontrar o padrão de string na expressão. Expressões Regulares ou Regex são strings com sintaxe especial. Ele permite que o usuário combine padrões em outras strings com base nos valores das strings.

O Regex é criado com base no tipo de dados e no requisito da expressão na string, como String = (.*)\n. O regex é usado antes do padrão em todas as expressões. Os símbolos usados nas expressões regulares estão listados abaixo e ajudarão a saber como analisar o texto.

- .: para recuperar qualquer caractere dos dados,

- *: use zero ou mais dados da expressão anterior,

- (.*): para agrupar uma parte da expressão regular entre parênteses,

- \n: Crie um novo caractere de linha no final da linha no código,

- \d: criar um valor integral curto no intervalo de 0 a 9,

- +: use um ou mais dados da expressão anterior e

- |: criar uma declaração lógica; usado para ou expressões.

Objetos Regex

O RegexObject é um valor de retorno para a função de compilação e é usado para retornar um MatchObject se a expressão corresponder ao valor de correspondência.

1. MatchObject

Como o valor booleano do MatchObject é sempre True, você pode usar um se para identificar as correspondências positivas no objeto. No caso de usar o se declaração, o grupo referido pelo índice é usado para descobrir a correspondência do objeto na expressão.

- grupo() retorna um ou mais subgrupos de correspondência,

- grupo (0) retorna a partida inteira,

- grupo 1) retorna o primeiro subgrupo entre parênteses e

- Ao nos referirmos a vários grupos, devemos usar uma extensão específica do python. Esta extensão é usada para especificar o nome do grupo no qual a correspondência deve ser encontrada. A extensão específica é fornecida dentro do grupo entre parênteses. Por exemplo, a expressão, (?P

regex1) se referiria ao grupo específico com o nome grupo 1 e verifique a correspondência na expressão regular, regex1. Para saber como corrigir o erro de parse, você deve verificar se o grupo está apontado corretamente.

2. Métodos de MatchObject

Ao descobrir como analisar o texto, é importante saber que o MatchObject tem dois métodos básicos listados abaixo. Se o MatchObject for encontrado na expressão especificada, ele retornará sua instância, caso contrário, retornará None.

- O corresponder (corda) método é usado para encontrar as correspondências da string no início da expressão regular e

- O seqüência de pesquisa) O método é usado para verificar a string para encontrar o local de uma correspondência na expressão regular.

Funções de Expressão Regular

Funções Regex são linhas de código usadas para executar uma determinada função conforme especificado pelo usuário a partir do conjunto de valores de dados adquiridos.

Observação: Para escrever as funções, strings brutas são usadas para as expressões regulares para evitar erros na análise do texto x. Isso é feito adicionando o subscrito r antes de cada padrão na expressão.

As funções comuns usadas nas expressões são explicadas abaixo.

1. re.encontrar()

Esta função retorna todos os padrões na string se uma correspondência for encontrada e retorna uma lista vazia se nenhuma correspondência for encontrada. Por exemplo, a função, string = re.findall('[aeiou]', regex_filename) é usado para localizar a ocorrência de vogal no nome do arquivo.

2. re.split()

Esta função é usada para dividir a string caso seja encontrada uma correspondência com um caractere especificado, como espaço. Caso nenhuma correspondência seja encontrada, ele retorna uma string vazia.

3. re.sub()

A função substitui o texto correspondente pelo conteúdo da variável de substituição fornecida. Ao contrário de outras funções, se nenhum padrão for encontrado, a string original é retornada.

4. pesquisar()

Uma das funções básicas para ajudar a aprender a analisar o texto é a função de pesquisa. Isso ajuda a pesquisar o padrão na string e retornar o objeto de correspondência. Se a pesquisa falhar na identificação da correspondência, nenhum valor será retornado.

5. re.compile (padrão)

Essa função é usada para compilar padrões de expressão regular em um RegexObject, que foi discutido anteriormente.

Outros requerimentos

Os requisitos listados são um recurso adicional usado por programadores avançados na análise de dados.

- Para visualizar a expressão regular, regexper é usado, e

- Para testar a expressão regular, regex101 é usado.

Leia também:Como instalar o NumPy no Windows 10

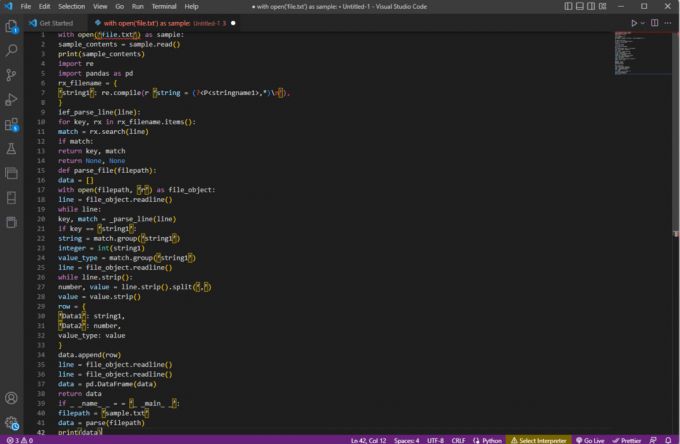

Processo de análise de texto

O método para analisar o texto nesta opção complexa é descrito abaixo.

- O passo mais importante é entender o formato de entrada lendo o conteúdo do arquivo. Por exemplo, o com aberto e ler() funções são usadas para abrir e ler o conteúdo do arquivo chamado amostra. O amostra arquivo tem o conteúdo do arquivo arquivo.txt; para saber como corrigir o erro de análise, o arquivo deve ser lido completamente.

- O conteúdo do arquivo é impresso para analisar os dados manualmente para descobrir os metadados dos valores. Aqui o imprimir() A função é usada para imprimir o conteúdo do amostra arquivo.

- Os pacotes de dados necessários para analisar o texto são importados para o código e um nome é dado à classe para posterior codificação. Aqui o expressões regulares e pandas são importados.

- As expressões regulares necessárias para o código são definidas no arquivo incluindo o padrão regex e a função regex. Isso permite que o objeto de texto ou corpus leve o código para análise de dados.

- Para saber como analisar o texto, você pode consultar o código de exemplo fornecido aqui. O compilar() função é usada para compilar a string do grupo stringname1 do arquivo nome do arquivo. A função para verificar correspondências no regex é usada pelo comando ief_parse_line (linha),

- O analisador de linha para o código é escrito usando o def_parse_file (arquivo), em que a função definida verifica todas as correspondências de regex na função especificada. Aqui, o regex procurar() método procura a chave rx no arquivo nome do arquivo e retorna a chave e a correspondência do primeiro regex correspondente. Qualquer problema com a etapa pode levar a um erro na análise do texto x.

- A próxima etapa é escrever um analisador de arquivo usando a função de analisador de arquivo, que é def_parse_file (arquivo). Uma lista vazia é criada para coletar os dados do código, conforme dados = [], a correspondência é verificada em cada linha por match = _parse_line (linha), e os dados do valor exato são retornados com base no tipo de dados.

- Para extrair o número e o valor da tabela, o comando line.strip().split(',') é usado. O linha{} O comando é usado para criar um dicionário com a linha de dados. O data.append (linha) O comando é usado para compreender os dados e analisá-los em um formato tabular.

O comando dados = pd. DataFrame (dados) é usado para criar um DataFrame pandas a partir dos valores dict. Como alternativa, você pode usar os seguintes comandos para a respectiva finalidade, conforme indicado abaixo.

- data.set_index(['string', 'integer'], inplace=True) para definir o índice da tabela.

- data = data.groupby (level=data.index.names).first() para consolidar e remover nans.

- data = data.apply (pd.to_numeric, errors='ignore') para atualizar a pontuação de flutuante para valor inteiro.

A etapa final para saber como analisar o texto é testar o analisador usando o se declaração atribuindo os valores a uma variável dados e imprimi-lo usando o imprimir (dados) comando.

O código de exemplo para a explicação acima é fornecido aqui.

com open('file.txt') como exemplo:sample_contents = sample.read()imprimir (sample_contents)importar reimportar pandas como pdrx_filename = {‘string1’: re.compile (r ‘string = (?,*)\n'),

}ief_parse_line (linha):para chave, rx em rx_filename.items():match = rx.search (linha)se corresponder:chave de retorno, correspondênciaretornar Nenhum, Nenhumdef parse_file (arquivo):dados = []com open (filepath, ‘r’) como file_object:linha = file_object.readline()enquanto linha:chave, correspondência = _parse_line (linha)if chave == ‘string1’:string = match.group('string1')inteiro = int (string1)value_type = match.group('string1')linha = file_object.readline()while line.strip():número, valor = line.strip().split(',')valor = valor.strip()linha = {'Dados1': string1,'Dados2': número,value_type: valor}data.append (linha)linha = file_object.readline()linha = file_object.readline()dados = pd. DataFrame (dados)dados de retornoif _ _name_ _ = = ‘_ _main_ _’:caminho do arquivo = ‘amostra.txt’data = parse (arquivo)imprimir (dados)

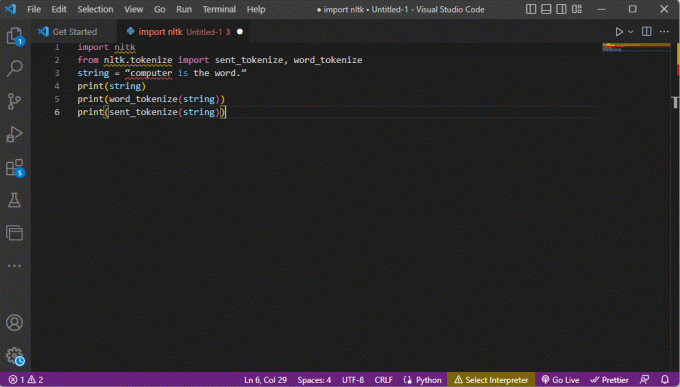

Método 2: Através da Tokenização do Word

O processo de converter um texto ou corpus em tokens ou pedaços menores com base em certas regras é chamado de tokenização. Para saber como corrigir o erro de parse, é importante analisar os comandos de tokenização de palavras no código. Semelhante ao regex, regras próprias podem ser criadas neste método e ajudam em tarefas de pré-processamento de texto, como mapeamento de partes do discurso. Além disso, atividades como localizar e combinar palavras comuns, limpar texto e preparar os dados para técnicas avançadas de análise de texto, como análise de sentimentos, são realizadas neste método. Se a tokenização for imprópria, pode ocorrer um erro na análise do texto x.

Biblioteca NLTK

O processo conta com a ajuda da popular biblioteca de kits de ferramentas de linguagem chamada NLTK, que possui um rico conjunto de funções para realizar muitos trabalhos de NLP. Eles podem ser baixados por meio dos pacotes Pip ou Pip Installs. Para saber como analisar o texto, você pode usar o pacote base da distribuição Anaconda que inclui a biblioteca por padrão.

Formas de Tokenização

As formas comuns desse método são a tokenização de palavras e a tokenização de sentenças. Devido ao token de nível de palavra, o primeiro imprime uma palavra apenas uma vez, enquanto o último imprime a palavra no nível de sentença.

Processo de análise de texto

- A biblioteca do kit de ferramentas NLTK é importada e os formulários de tokenização são importados da biblioteca.

- Uma string é fornecida e os comandos para executar a tokenização são fornecidos.

- Enquanto a string é impressa, a saída seria computador é a palavra.

- No caso de tokenização de palavras ou palavra_tokenize(), cada palavra na frase é impressa individualmente dentro do ‘’ e é separado por um vírgula. A saída para o comando seria o 'computador', 'é', 'o', 'palavra', '.'

- No caso de tokenização de sentença ou sent_tokenize(), as frases individuais são colocadas dentro do ‘’ e a repetição de palavras é permitida. A saída para o comando seria 'computador é a palavra.'

O código que explica as etapas para tokenização acima é fornecido aqui.

importar nltkde nltk.tokenize import sent_tokenize, word_tokenizestring = “computador é a palavra.”imprimir (corda)imprimir (word_tokenize (string))imprimir (sent_tokenize (string))

Leia também:Como corrigir javascript: void (0) Error

Método 3: por meio da classe DocParser

Semelhante à classe DataFrame, a classe DocParser pode ser usada para analisar o texto no código. A classe permite que você chame a função de análise com o caminho de arquivo.

Processo de análise de texto

Para saber como analisar texto usando a classe DocParser, siga as instruções abaixo.

- O get_format (nome do arquivo) A função é usada para extrair a extensão do arquivo, retorná-la a uma variável definida para a função e passá-la para a próxima função. Por exemplo, p1 = get_format (nome do arquivo) extrairia a extensão do arquivo de nome do arquivo, configure-o para a variável p1, e passe-o para a próxima função.

- Uma estrutura lógica com outras funções é construída usando o if-elif-else declarações e funções.

- Se a extensão do arquivo for válida e a estrutura for lógica, o get_parser A função é usada para analisar os dados no caminho do arquivo e retornar o objeto de string para o usuário.

Observação: Para saber como corrigir o erro de análise, esta função deve ser implementada corretamente.

- A análise dos valores de dados é feita com a extensão de arquivo do arquivo. A implementação concreta da classe, que são parse_txt ou parse_docx é usado para gerar objetos de string das partes do tipo de arquivo fornecido.

- A análise pode ser feita para arquivos de outras extensões legíveis, como parse_pdf, parse_html, e parse_pptx.

- Os valores de dados e a interface podem ser importados para aplicativos com instruções de importação e instanciar um objeto DocParser. Isso pode ser feito analisando arquivos na linguagem Python, como parse_file.py. Esta operação deve ser feita com cuidado para evitar erros na análise do texto x.

Método 4: Através da Ferramenta Analisar Texto

A ferramenta Analisar texto é usada para extrair dados específicos de variáveis e mapeá-los para outras variáveis. Isso é independente de quaisquer outras ferramentas usadas em uma tarefa e a ferramenta BPA Platform é usada para consumir e gerar variáveis. Use o link fornecido aqui para acessar o Analisar ferramenta de texto on-line e use as respostas fornecidas anteriormente sobre como analisar o texto.

Método 5: Através de TextFieldParser (Visual Basic)

O TextFieldParser utilizou objetos para analisar e processar arquivos muito grandes que são estruturados e delimitados. A largura e a coluna de texto, como arquivos de log ou informações do banco de dados herdado, podem ser usadas neste método. O método de análise é semelhante à iteração do código em um arquivo de texto e é usado principalmente para extrair campos de texto semelhantes aos métodos de manipulação de strings. Isso é feito para tokenizar strings delimitadas e campos de várias larguras usando o delimitador definido, como vírgula ou espaço de tabulação.

Funções para Analisar Texto

As seguintes funções podem ser usadas para analisar o texto neste método.

- Para definir um delimitador, o DefinirDelimitadores é usado. Por exemplo, o comando testReader. SetDelimiters (vbTab) é usado para definir aba espaço como delimitador.

- Para definir uma largura de campo para um valor inteiro positivo para uma largura de campo fixa de arquivos de texto, você pode usar o testReader. SetFieldWidths (inteiro) comando.

- Para testar o tipo de campo do texto, você pode usar o seguinte comando testReader. TextFieldType = Microsoft. Visual básico. FileIO.FieldType. Largura fixa.

Métodos para localizar MatchObject

Existem dois métodos básicos para localizar o MatchObject no código ou no texto analisado.

- O primeiro método é definir o formato e percorrer o arquivo usando o ReadFields método. Esse método ajudaria no processamento de cada linha do código.

- O PeekChars O método é usado para verificar cada campo individualmente antes de lê-lo, definir vários formatos e reagir.

Em ambos os casos, se um campo não corresponder ao formato especificado ao executar a análise ou descobrir como analisar o texto, um MalformedLineException exceção é retornada.

Dica Profissional: Como Analisar Texto Através do MS Excel

Como um método final e simples para analisar o texto, você pode usar o Excel app como um analisador para criar arquivos delimitados por tabulações e delimitados por vírgulas. Isso ajudaria na verificação cruzada com o resultado analisado e ajudaria a descobrir como corrigir o erro de análise.

1. Selecione os valores de dados no arquivo de origem e pressione o botão Teclas Ctrl + C juntos para copiar o arquivo.

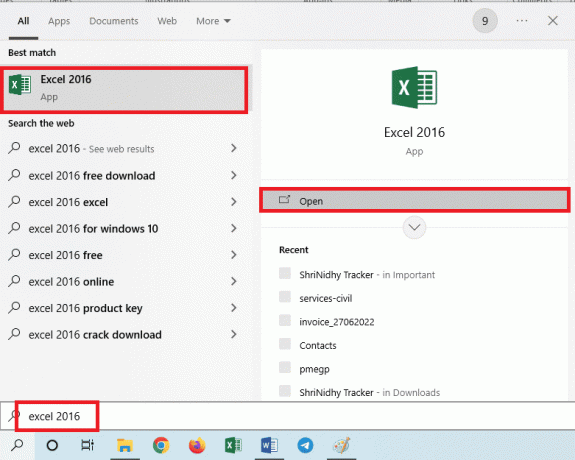

2. Abra o excel aplicativo usando a barra de pesquisa do Windows.

3. Clique no A1 célula e pressione a tecla Teclas Ctrl + V simultaneamente para colar o texto copiado.

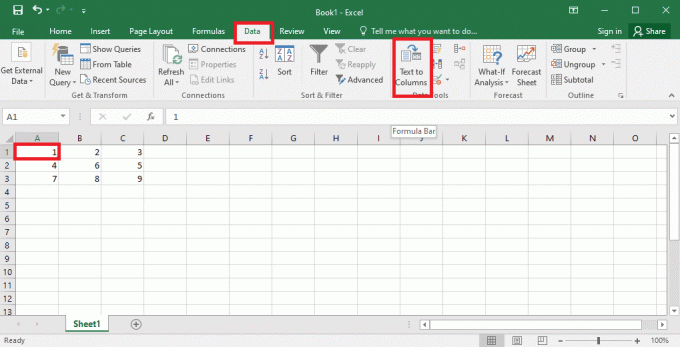

4. Selecione os A1 celular, navegue até o Dados guia e clique no botão Texto para colunas opção no Ferramentas de Dados seção.

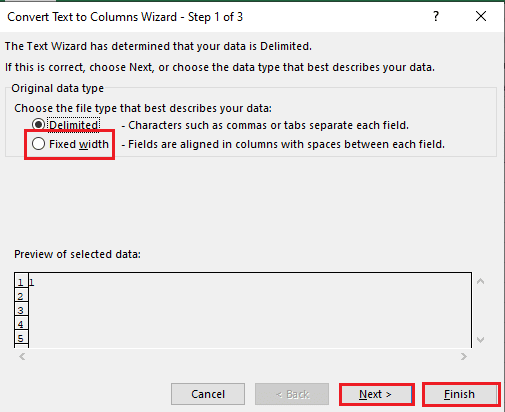

5A. Selecione os delimitado opção se um vírgula ou aba espaço é usado como separador e clique no botão Próximo e Terminar botões.

5B. Selecione os Largura fixa opção, atribua um valor para o separador e clique no botão Próximo e Terminar botões.

Leia também:Como Corrigir o Erro de Coluna Mover do Excel

Como corrigir erro de análise

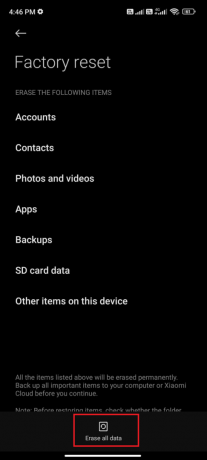

Erro na análise de texto x pode ocorrer em dispositivos Android como, Erro de análise: houve um problema ao analisar o pacote. Isso geralmente ocorre quando o aplicativo falha na instalação da Google Play Store ou durante a execução de um aplicativo de terceiros.

O texto de erro x pode ocorrer se a lista de vetores de caracteres estiver em loop e outras funções formarem um modelo linear para calcular os valores dos dados. A mensagem de erro é Error in parse (text = x, keep.source = FALSE):

Você pode ler o artigo em como corrigir erro de parse no Android para aprender as causas e métodos para corrigir o erro.

Além das soluções do guia, você pode tentar as seguintes correções.

- Baixando novamente o .apk arquivo ou restaurar o nome do arquivo.

- Restaurar alterações no Androidmanifest.xml arquivo, se você tiver habilidades de programação em nível de especialista.

Recomendado:

- Como excluir a conta do Facebook de outra pessoa

- As 10 principais habilidades necessárias para se tornar um hacker ético

- 21 melhores alternativas Pastebin para compartilhar código e texto

- Corrigir comando falhou com código de erro 1 Python Egg Info

O artigo ajuda no ensino como analisar texto e aprender como corrigir erros de análise. Deixe-nos saber qual método ajudou a corrigir o erro na análise do texto x e qual método de análise é o preferido. Por favor, compartilhe suas sugestões e dúvidas na seção de comentários abaixo.